データクリーニング | Webクローラ | ScrapeStorm

摘要:データクリーニング (Data cleaning) は、データ分析およびマイニング プロセスの重要なステップです。 これには、データの品質と信頼性を確保するために、データセットの不正確な部分、不完全な部分、冗長な部分、または矛盾した部分を特定、修正、削除することが含まれます。 データ クリーニングの主な目的は、データをさらなる分析とモデリングに適したものにして、分析の精度と信頼性を高めることです。 ScrapeStorm無料ダウンロード

ScrapeStormとは、強い機能を持つ、プログラミングが必要なく、使いやすい人工知能Webスクレイピングツールです。

概要

データクリーニング (Data cleaning) は、データ分析およびマイニング プロセスの重要なステップです。 これには、データの品質と信頼性を確保するために、データセットの不正確な部分、不完全な部分、冗長な部分、または矛盾した部分を特定、修正、削除することが含まれます。 データ クリーニングの主な目的は、データをさらなる分析とモデリングに適したものにして、分析の精度と信頼性を高めることです。

適用シーン

市場調査、顧客関係管理、広告キャンペーンでは、データをクリーニングすることで顧客情報の正確性が保証され、対象ユーザーをより適切に絞り込むことが可能になります。 銀行や金融機関は、不正行為の検出、信用スコアリング、リスク管理のために取引データをクリーンアップする必要があります。 IoT 環境では、デバイスのパフォーマンスを監視および制御するために、大量のセンサー データをクリーンアップして処理する必要があります。

メリット:クレンジングによりデータ内のエラー、重複、不一致が除去されるため、データの精度が向上し、より信頼性の高い意思決定が可能になります。 無効なデータまたは破損したデータを削除することで、データの品質が向上し、データの不正確さが減少します。 クレンジングにより、データセット全体でデータの一貫性が確保され、適切な比較と分析が可能になります。

デメリット:クレンジングによりデータ内のエラー、重複、不一致が除去されるため、データの精度が向上し、より信頼性の高い意思決定が可能になります。 無効なデータまたは破損したデータを削除することで、データの品質が向上し、データの不正確さが減少します。 クレンジングにより、データセット全体でデータの一貫性が確保され、適切な比較と分析が可能になります。

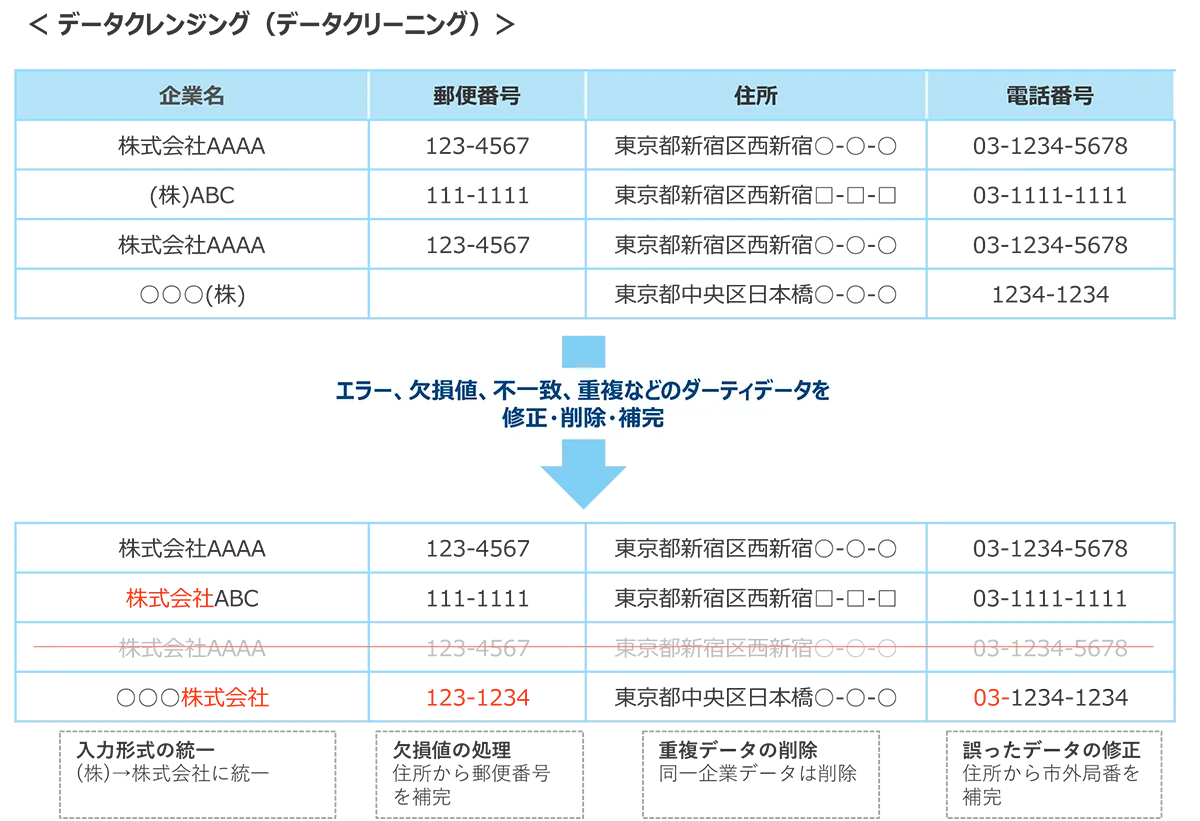

図例

1. データクリーニングの具体例。

2. データクリーニングの具体例。

関連記事

参考リンク

https://gmo-research.jp/research-column/data-cleaning