【Webスクレイピング】データ収集はどのように行われますか? | Webクローラ | ScrapeStorm

摘要:データ収集は、情報やデータを集めるプロセスのことです。データ収集により、トレンドの把握、パターンの発見、市場動向の分析などが可能になります。ビジネスや組織において、意思決定をサポートするための情報やデータを収集します。市場調査、顧客の嗜好や行動の把握、競合情報の収集などが行われます。 ScrapeStorm無料ダウンロード

データ収集の目的

データ収集は、情報やデータを集めるプロセスのことです。データ収集により、トレンドの把握、パターンの発見、市場動向の分析などが可能になります。ビジネスや組織において、意思決定をサポートするための情報やデータを収集します。市場調査、顧客の嗜好や行動の把握、競合情報の収集などが行われます。

では、データ収集作業はどのように行われるのでしょうか?この記事では、データ収集の流れを簡単に紹介します。

1. ニーズを明確にする

まず、どのデータを必要としているのか、どの属性や変数などの情報が必須なのかを明確にする必要があります。例えば、商品の価格、映画のレビュー、物件の価格など。これにより、データ収集の方向や範囲を決定するのに役立ちます。

2. データソースを決定する

データソースを決定します。どのサイト、データセット、APIなどからデータを取得することができ、データ収集の範囲を縮小するのに役立ちます。

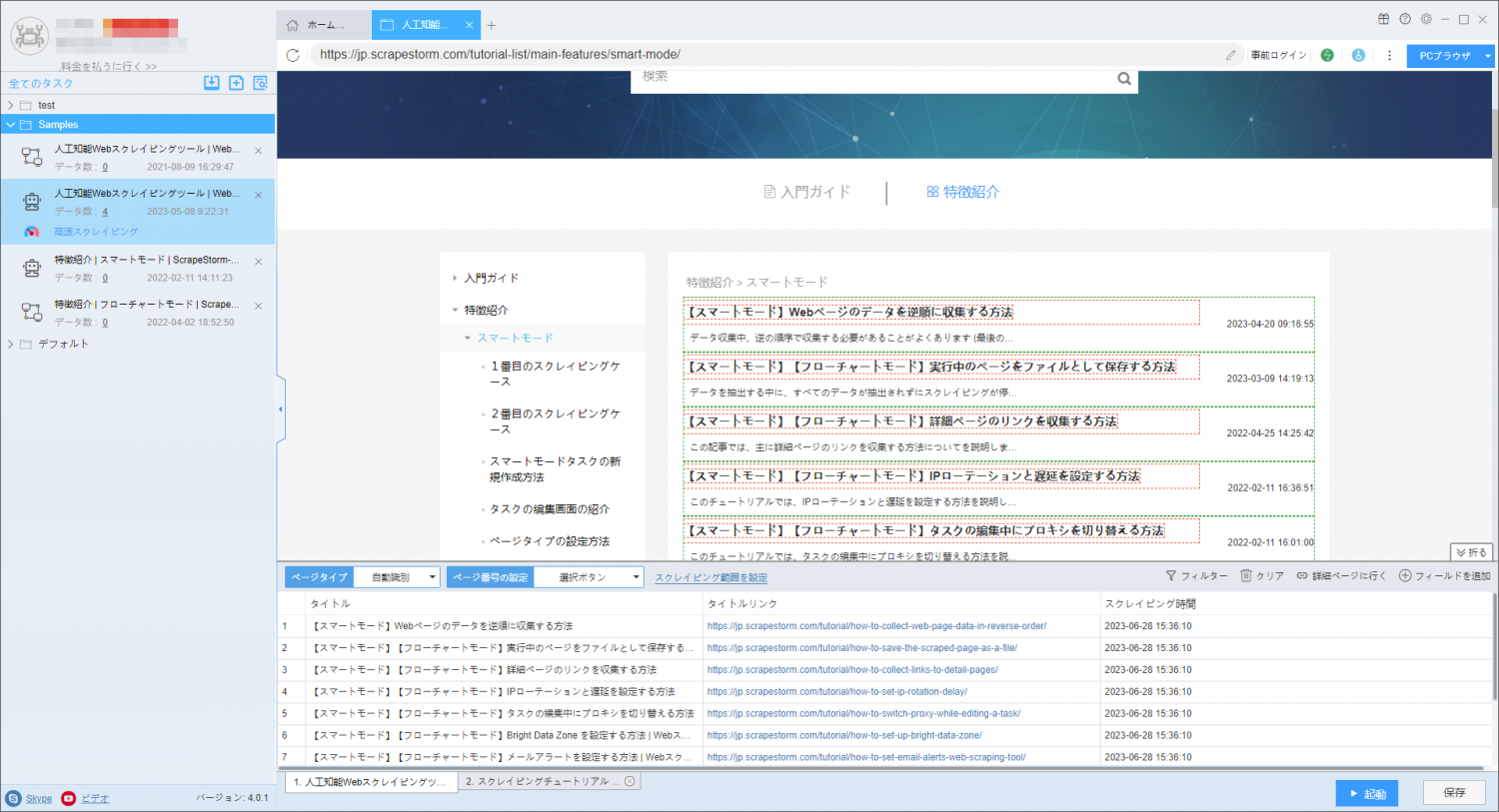

3. データ収集の方法

データソースによって異なる収集方法を使用します。サイトデータには、Webスクレイピングツール、APIデータにはAPIを呼び出す方法などを使用することができます。

4. データのクリーニングと処理

収集されたデータは重複、エラーなどの問題がある可能性があり、データの品質を確保するためにデータのクリーニングと処理を行う必要があります。

5. データの分析と応用

収集されたデータは、機械学習、データマイニングなどの分析と応用にします。

データ収集には、関連する法律法規と倫理基準に従う必要があり、他人のプライバシーなどの権利を侵害してはならないことに注意しなければならない。同時に、データの保護とセキュリティ処理を行い、データの漏洩と乱用を防止する必要があります。

免責事項: 本文はユーザーが提供して、侵害がありましたら、ご連絡してすぐに削除します。ScrapeStormは、ユーザーが本ソフトウェアを使って行うすべての行為に対して、一切責任を負いません。