【2024更新】データ抽出に最適なWebスクレイピングツール 5選 | Webクローラ | ScrapeStorm

摘要:Webスクレイピングツールは、Webサイト上で必要な情報を取得するように設計されています。 このようなツールを使用すると、データ抽出にかかる時間を大幅に節約できます。 ここでは、五つのより優れた機能と効果を備えたWebスクレイピングツールを紹介します。 ScrapeStorm無料ダウンロード

Webスクレイピングツールは、Webサイト上で必要な情報を取得するように設計されています。 このようなツールを使用すると、データ抽出にかかる時間を大幅に節約できます。

ここでは、五つのより優れた機能と効果を備えたWebスクレイピングツールを紹介します。

1.ScrapeStorm

ScrapeStormとは、強い機能を持つ、プログラミングが必要なく、使いやすい人工知能Webスクレイピングツールです。違う基盤のユーザに二つのスクレイピングモードを提供し、1-Clickで99%のWebスクレイピングを満たします。ScrapeStormにより、大量のWebデータを素早く正確的に取得できます。手動でデータ抽出が直面するさまざまな問題を完全に解決し、情報取得のコストを削減し、作業効率を向上させます。

特徴:

①業界をリードする技術を備えたScrapeStormは、Windows、Mac、およびLinuxの全オペレーティングシステムに適切する。

②データ処理と重複排除機能があり、スクレイピング中にデータをクリーニングする。

③スケジュール機能により、定期的なスケジュールでデータを収集できます。タスクの起動時間と停止時間を設定できる。

④日本語サービスが提供する。

2.Import.io

このWebスクレイピングツールは、特定のWebページからデータをインポートし、データをCSVにエクスポートすることにより、データセットを形成するのに役立ちます。 APIとWebhookを使用してアプリケーションにデータを統合できます。

特徴:

①データ抽出をスケジュールできる。

②Import.ioクラウドを使用してデータを保存およびアクセスできる。

③報告、図表、可視化によって見解を得る。

④Webインタラクションとワークフローを自動化する。

3.Dexi.io

Dexi.io(以前はCloudScrapeとしても知られていました)は、クラウドベースのWebスクレイピングプラットフォームであり、データ収集と自動化を容易にするために設計されています。

特徴:

①Dexi.ioはスクレイピングタスクの自動化をサポートしており、定期的なスケジュールでデータを収集できます。これにより、定期的なデータ更新や監視が可能になる。

②Dexi.ioはクラウドベースのプラットフォームであり、自分のコンピュータにソフトウェアをインストールする必要がなく、どこからでもアクセスできる。

③収集したデータをCSV、JSON、Excelなどのフォーマットでエクスポートできます。また、API経由でデータを送信することもできる。

4.Mozenda

Mozendaを使用すると、Webページからテキスト、画像、PDFコンテンツを抽出できます。 これは、発行用のデータファイルを整理して準備するのに役立ちます。

特徴:

①Webデータを収集して、好みのBlツールまたはデータベースに公開できる。

②point-and-clickインターフェイスを提供し、数分間でWebスクレイピングエージェントを作成する。

③ジョブシーケンサーとリクエストブロッキング機能を利用して、リアルタイムでWebデータを収集する。

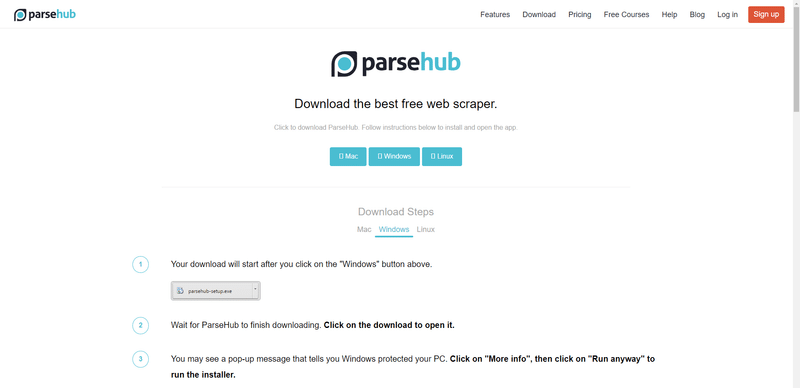

5.ParseHub

ParseHubは無料のWebスクレイピングツールです。 この高度なWebスクレイパーを使用すると、必要なデータをクリックするだけでデータを抽出できます。 それは分析のために任意のフォーマットで収集されたデータをダウンロードすることを可能にします。

特徴:

①使いやすいインターフェイス

②データをダウンロードする前にテキストとHTMLをクリーンアップ

③サーバー上のデータを自動的に収集して保存する

免責事項: 本文はユーザーが提供して、侵害がありましたら、ご連絡してすぐに削除します。ScrapeStormは、ユーザーが本ソフトウェアを使って行うすべての行為に対して、一切責任を負いません。