Robots.txt | Webクローラ | ScrapeStorm

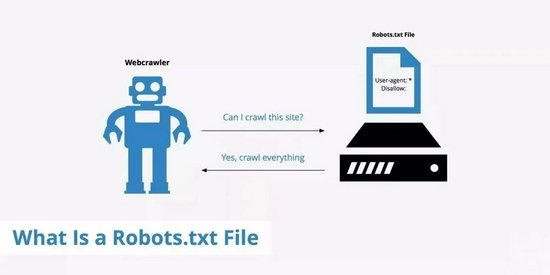

摘要:ロボット プロトコル (クローラー プロトコル、クローラー ルールなどとも呼ばれます) とは、Web サイトが robots.txt ファイルを作成して、どのページがクロール可能でどのページがクロールできないかを検索エンジンに伝えることができ、検索エンジンはそのファイルを読み取ることでそれらを識別できることを意味します。 robots.txt ファイル。このページのクロールを許可するかどうか。 ただし、この Robots プロトコルはファイアウォールではなく強制力がないため、検索エンジンは robots.txt ファイルを完全に無視して、Web ページのスナップショットを取得することができます。 ScrapeStorm無料ダウンロード

ScrapeStormとは、強い機能を持つ、プログラミングが必要なく、使いやすい人工知能Webスクレイピングツールです。

概要

Robots.txt とは、Web サイトが robots.txt ファイルを作成して、どのページがクロール可能でどのページがクロールできないかを検索エンジンに伝えることができ、検索エンジンはそのファイルを読み取ることでそれらを識別できることを意味します。 robots.txt ファイル。このページのクロールを許可するかどうか。 ただし、この Robots プロトコルはファイアウォールではなく強制力がないため、検索エンジンは robots.txt ファイルを完全に無視して、Web ページのスナップショットを取得することができます。

適用シーン

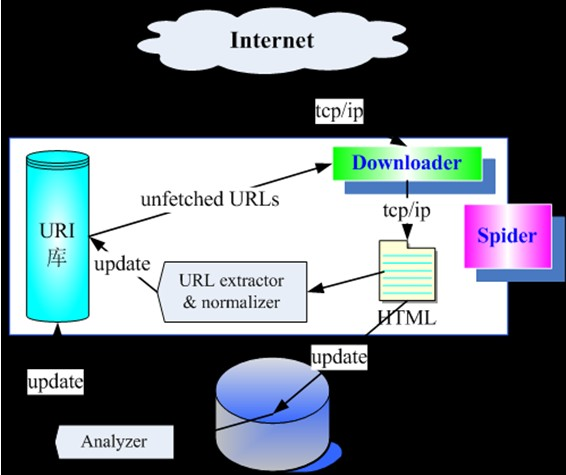

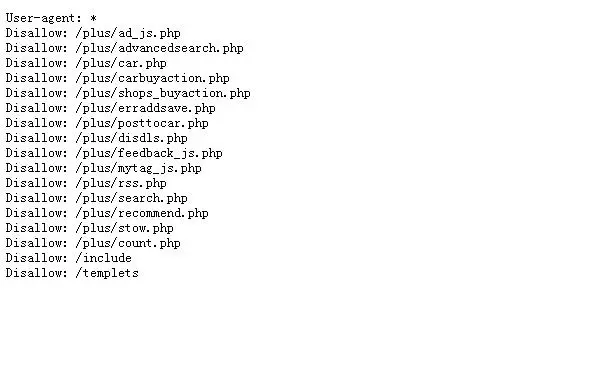

Robots.txtの目的は、Web サイト管理者が検索エンジン スパイダーのアクセスを制御して、プライベート コンテンツを保護し、サーバーの負荷を軽減し、スパイダーをサイトの特定の部分に誘導できるようにすることです。Robots.txtでは、「ユーザー エージェント」(スパイダーを指定する) や「禁止」(禁止されたアクセス パスを指定する) など、検索エンジン スパイダーが Web サイトをクロールする方法をガイドするために使用されるいくつかの命令が規定されています。

このプロトコルは、検索エンジン最適化 (SEO) と Web サイトのセキュリティの両方にとって重要であり、Web マスターは robots.txt を使用して、検索エンジンに公開するコンテンツとインデックスを作成しないコンテンツを指定できます。

メリット:Robots.txtを使用すると、Web サイト管理者は検索エンジン スパイダーへのアクセスを明示的に制御できるため、Web サイト コンテンツのプライバシーとセキュリティが維持されます。 これにより、サーバーの負荷が軽減され、Web サイトのパフォーマンスが向上すると同時に、さまざまな検索エンジンに合わせてさまざまなルールをカスタマイズして、クロール動作をより細かく制御できるようになります。 さらに、Robots.txtは、検索エンジンが同じコンテンツの複数のコピーに繰り返しインデックスを作成することを防ぎ、検索結果の品質を向上させます。

デメリット:まず第一に、すべての検索エンジンがこれらのルールに従うわけではなく、一部の悪意のあるクローラーがプロトコルに従わない可能性があるため、これは Web サイトのセキュリティ対策ではありません。 次に、どのページをクロールしないように指定することは可能ですが、これはページのコンテンツが非公開であることを意味するものではありません。 Robots.txtは検索エンジンのための単なるガイドであり、実際のセキュリティ対策ではありません。 さらに、Robots.txtは検索エンジン スパイダーの単なるガイドであるため、ユーザーが禁止されたページに直接アクセスすることを防ぐことはできません。 最後に、ロボット プロトコルを正しく構成する必要があります。そうしないと、検索エンジンが Web サイトの重要なコンテンツのインデックスを作成できない可能性があるため、慎重に構成および維持する必要があります。

図例

1. Robots.txtの構造。

2. Robots.txtの書き方例。

関連記事

参考リンク

https://webbu.jp/robots-txt-5484